昨晚,AI 界估计又熬了个大夜,两大开源巨头纷纷发布最新模型(更新版本)。

DeepSeek 发布 V3.1-Terminus(最终版) 版本。阿里则是先后发布了 Qwen-Image-Edit-2509(图片编辑)、Qwen3-Omni(全模态)、Qwen3-TTS-Flash(语音合成)。

下面带大家看看都有什么内容。

DeepSeek V3.1-Terminus

感觉 Terminus(最终版)这个命名充满了预言,3.1的终版,那 V4 应该快了,不过我估计 R2 应该不会出现了,应该会合并成单一模型发布。

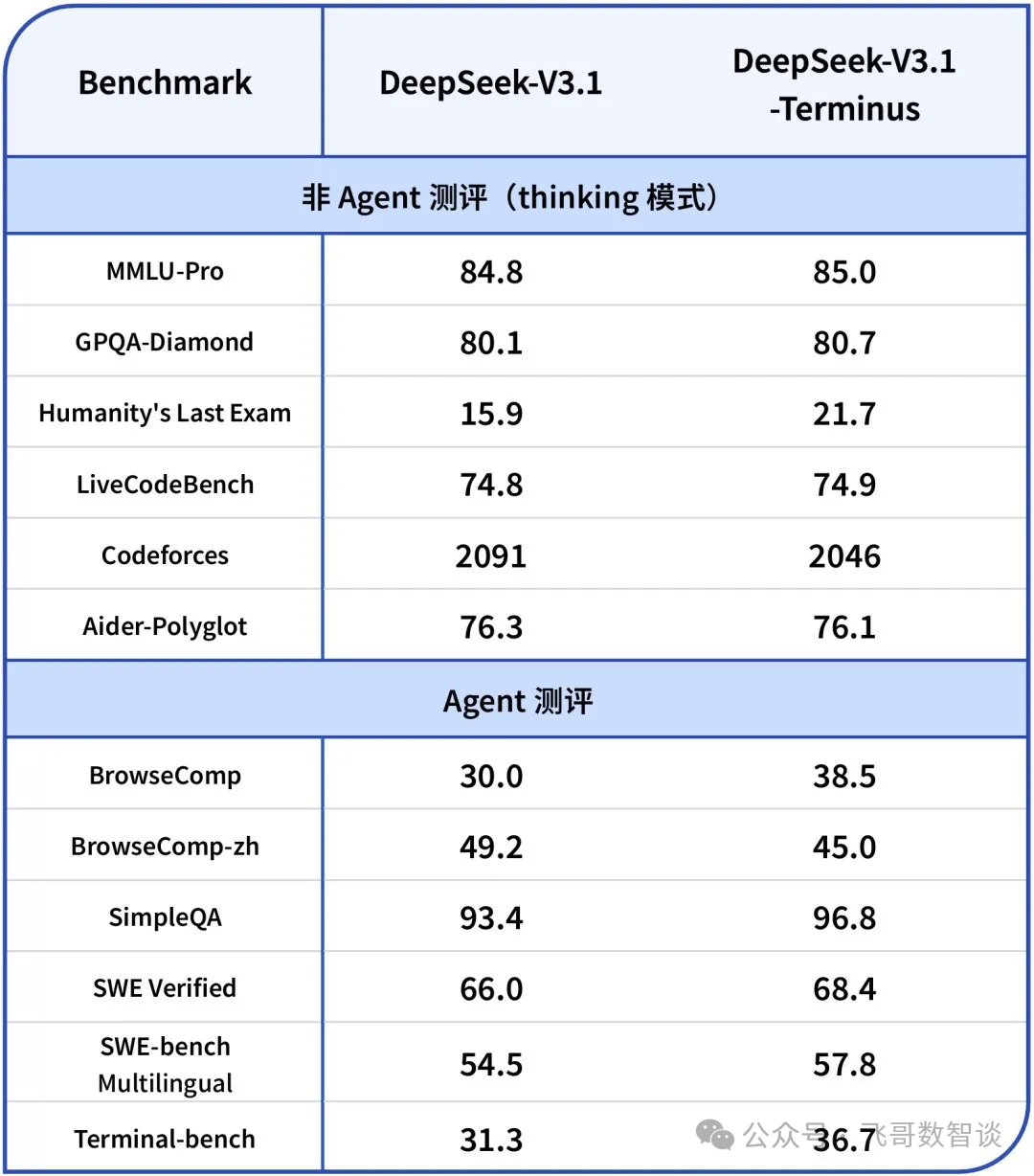

主要改进如下:

语言一致性优化:修复此前版本中英文混杂、尤其是随机输出“极”字等异常字符的问题。 Agent 能力提升:进一步优化了 Code Agent 与 Search Agent 的表现,这也坐实了前一阵传言的 DeepSeek 正在大力提升模型 Agent 能力。

模型已同步上线 Hugging Face 和 ModelScope 平台,官方App、网页端、API都可体验。

Qwen-Image-Edit-2509

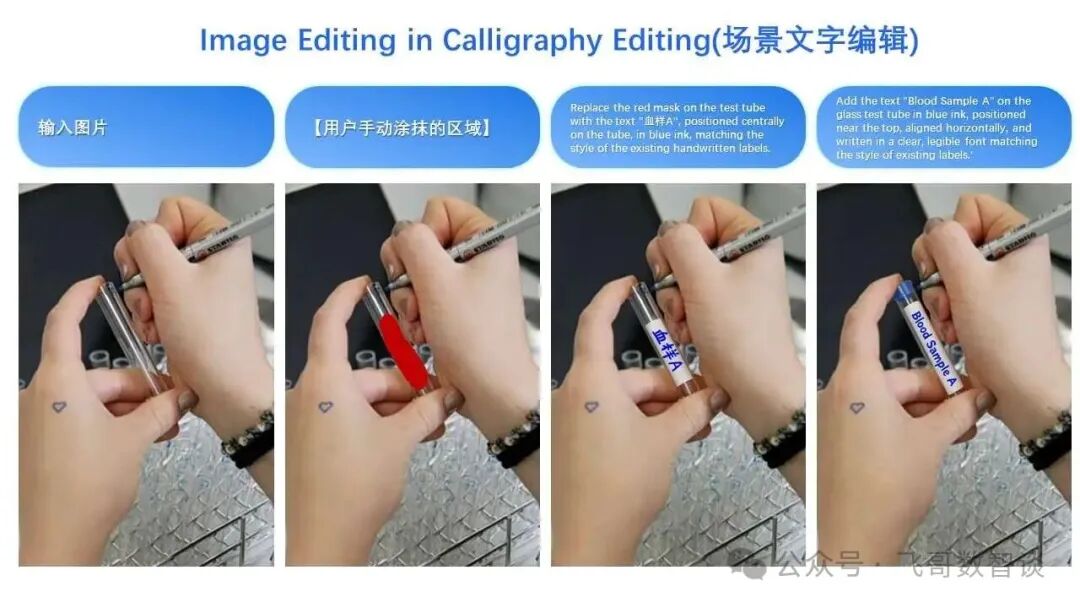

相比于 8 月发布的 Qwen-Image-Edit,这次更新提升主要体现在:

多图编辑能力支持:直接把多张图拖进对话框,Qwen 能自动理解图片关系,并进行“无缝融合”,这对做电商、做营销的朋友来说,简直是效率神器。 单图一致性增强:无论是人脸、产品,还是文字,可以方便进行各种变换、编辑的同时,还能保证原有特征不丢失。 原生支持 ControlNet:经常做生图的朋友应该开心了,不需要再通过各种方式“嫁接”了。

Qwen3-Omni

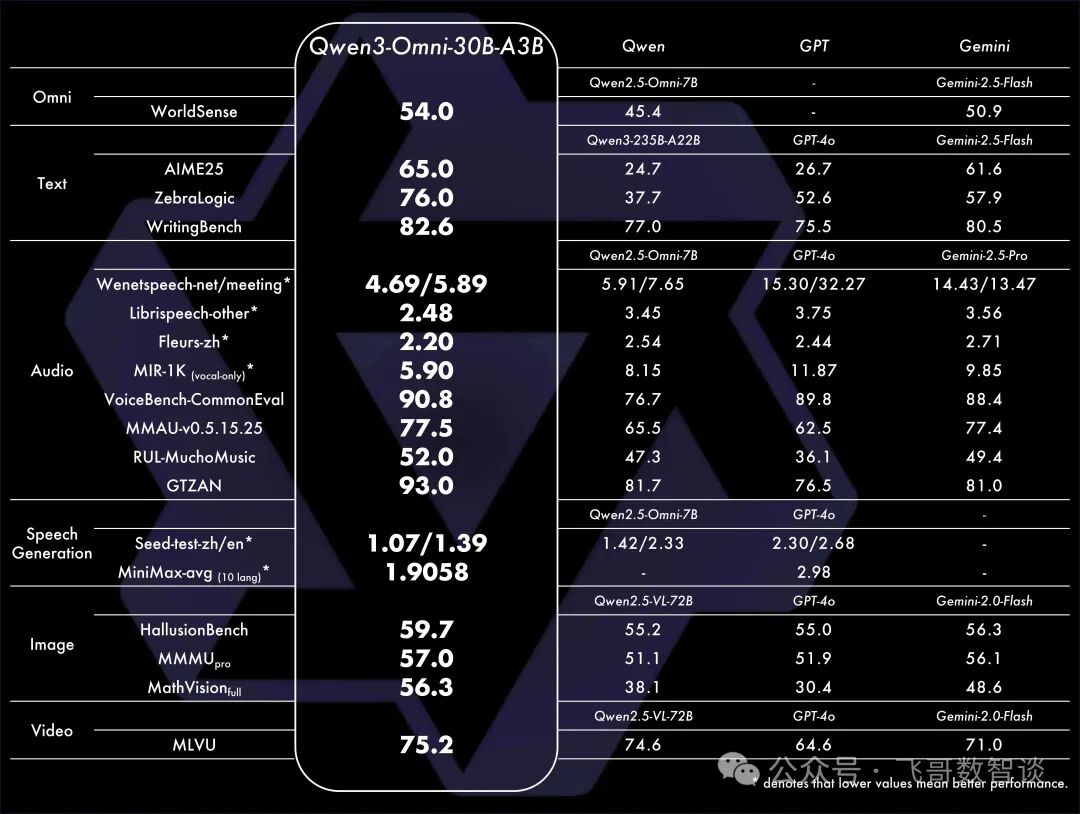

看了发布,这个模型相比于之前发布的多模态模型,突破性在于它真正实现了全模态输入与输出的原生统一,这个感觉很有搞头,后续可以再深入研究下。

原生全模态:从预训练阶段就融合文本、图像、音频、视频,不降智、不拼接,真正实现多模态原生统一理解与生成。 强大的性能:在36项音视频基准测试中斩获32项开源SOTA、22项总榜SOTA,超越Gemini-2.5-Pro、GPT-4o等闭源模型,图像与文本能力同尺寸也达SOTA。 更快响应:端到端音频对话延迟低至211ms,视频对话仅507ms,实时交互体验拉满。 开源通用音频Captioner:同步开源Qwen3-Omni-30B-A3B-Captioner,低幻觉、高细节,填补开源社区通用音频描述模型空白。

Qwen3-TTS-Flash

这个咋看起来没有那么亮眼,但实际用起来还不错——尤其是天津话一开口,自带听相声氛围。

极速推理:专为低延迟场景优化,合成速度比常规TTS模型快数倍,适合实时对话、直播、游戏等强交互场景。 高自然度语音:在韵律、情感、语调上全面升级,输出语音更接近真人表达,告别机械感。 多语言&多方言支持:覆盖主流语种,并支持中文方言(如粤语、四川话等),满足全球化与本地化双重需求。 轻量高效:模型体积小、资源占用低,可在边缘设备或移动端流畅运行,部署门槛大大降低。

结语

虽然,国内的 AI 和国外闭源的竞品还有一些差距,但开源方面,DeepSeek 和 Qwen 的动作真的值得称赞。

鲁公网安备37011202002305

鲁公网安备37011202002305